中国联通为何进军大模型?今天的关注度非常高,直接上了热搜榜,那么具体的是什么情况呢,大家可以一起来看看具体都是怎么回事吧。今年初以来,ChatGPT横空出世,引爆新一轮机器学习革命,大模型成为炙手可热的科技新赛道。据不完全统计,国内已有近百个大模型产品面世。

在大模型产业生态中,运营商没有缺席。运营商拥有强大的底层算力和网络基础设施,而且近年来不断加强研发投入,已有较为充分的技术积累。目前,三大运营商均发布了各自的大模型产品,其中,中国联通在MWC上海2023期间发布了鸿湖图文大模型1.0。

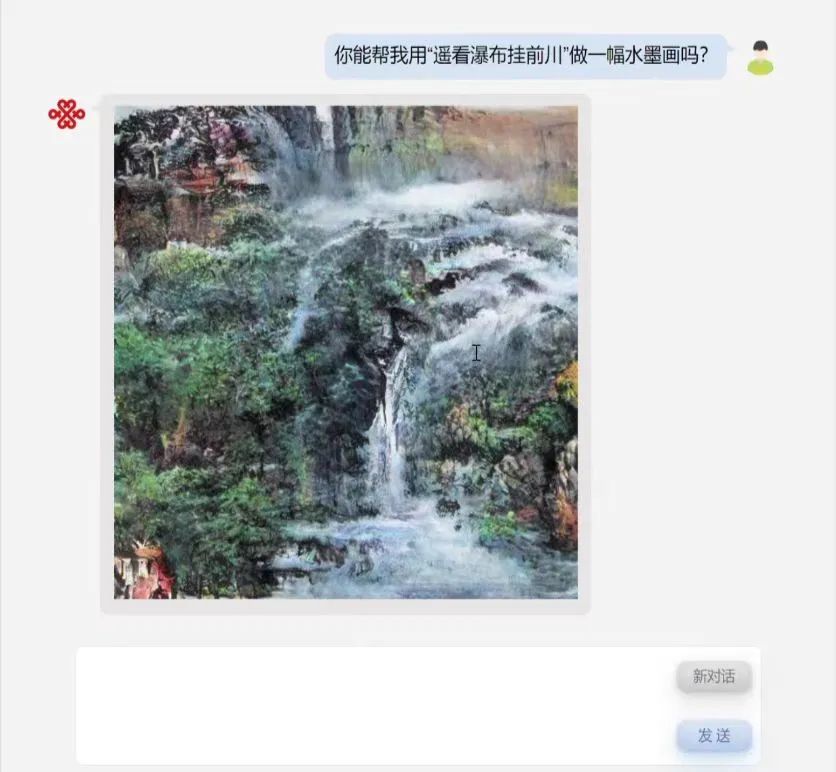

鸿湖图文大模型是首个面向运营商增值业务的大模型,具备以文生图、视频剪辑、以图生图等多种功能。日前,中国联通研究院智能技术研究部大模型项目负责人吴浩然接受媒体采访,对中国联通在大模型领域的布局进行了观点分享。

大模型将成为新一代流量入口

吴浩然首先强调,大模型是人工智能新一轮爆发的转折点,也是AGI(通用人工智能)时代的原点。其泛化能力将AI从过去单一场景适配的方式解放,类似工业革命从小作坊生产发展为工厂批量化生产,这意味着根本性的改变。

同时,随着大模型语言能力的发展以及目前的混合专家系统模式,以自然语言交互大模型做“管家”的模式,很可能会成为下一个时代的主流。如中信智库的报告所言,大模型将成为新一代流量入口。

做流量生意正是运营商的强项。吴浩然表示,从商业价值角度讲,中国联通布局大模型领域是非常必要的。运营商在移动互联网时代未能利用好流量,成为了“管道运营商”,在智能互联时代必须积极尝试转变,成为新时代的“综合数字服务运营商”。

吴浩然还认为,随着大模型技术进一步发展,极有可能成为新时代的操作系统。而美国对我国科技封锁愈加严苛,除芯片外,在大模型方面实际上也在加强打压。为防止重蹈过去很多工业软件被“卡脖子”的覆辙,中国联通和其他运营商作为央企中在AI方向较强的企业,布局大模型也符合国家政府期许,是中国联通积极承担央企责任的体现。

鸿湖图文大模型优势解析

目前,云计算、AI、互联网、游戏等领域企业都在发布大模型产品,市场上已是“百模大战”。那么,中国联通的鸿湖图文大模型,有何差异化优势?

吴浩然表示,鸿湖图文大模型不同于政务、客服等纯语言模型,从一开始就是图文双模态的模型。“其实我们布局大模型相对较早,在2021年即开始了相关技术研究,目前的鸿湖是在2022年即启动研发,当时ChatGPT尚未出现,Midjourney、Stable Diffusion这类文生图模型也还在酝酿。随着5G新通信的功能强化,我们从公众线的增值业务场景出发,瞄准了图文双模态。”

鸿湖图文大模型的差异化优势是特征融合,将不同模态内容对齐到文本,来实现跨模态的内容理解。据介绍,中国联通采取了Encoder-Decoder模式,这种模式在生成任务上灵活性相较Decoder-only弱,但在理解能力上更强,更符合做跨模态理解的需求。

吴浩然表示,鸿湖图文大模型目前是图文,也可以将提取部分改为图声或其他模态提取器,同样进行特征融合和跨模态对比学习后,可以很容易扩展至其他跨模态,最终实现不同模态在文本语义上统一的目标。“松耦合和强扩展性特征,也构成了竞争力的一环。只要我们做好模态融合部分,特征提取就可以时刻选取市面最好的模型来替换,保持我们模型的活力。”

大模型四大发展趋势

在研发鸿湖图文大模型的同时,中国联通也在探讨大模型产业的未来发展趋势。在吴浩然看来,主要有四大趋势:

首先,模态融合一定是最大的趋势。单模态的仍称不上AGI,融合所有模态再进一步发展后,才能迎来AGI。

其次,混合专家系统类思路是目前大模型落地比较优质的路径。过去十几年来,人工智能尤其是深度学习技术的发展积累了很多优质的模型,将大模型与这些模型结合,乃至将大模型与各类数字化系统结合、与机器部件结合,将是未来大模型由纯数字经济,向数字经济赋能实体经济转变的重要途径。

再次,大模型稀疏化是未来大模型落地的重要路径之一。当前大模型参数量仍呈快速增长态势,稠密大模型的计算推理势必将占用极大的算力资源,阻碍大模型的快速落地和泛在服务。而大模型稀疏化将极大降低大模型的部署成本,提高推理速度,使大模型真正“飞入寻常百姓家”。

最后,大模型短期内仍会以C端场景为主落地。B端由于存在大量判别式场景,仍需模型能力进一步增强。但长期来看,能否解决判别式场景的高精度同时保持高度泛化能力,是未来大模型能否在B端广泛应用的决定性因素,可以说C端决定未来大模型下限,B端决定上限。

基于对未来的趋势判断,吴浩然强调,中国联通将持续投资大模型赛道。目前来看,中国联通面临大模型研发人才积累不足、相关赛道的产品化经验不足等挑战,正在努力补强。同时,大模型虽然喧嚣,还处在Gartner技术成熟度曲线顶峰的左侧,是一个长线赛道。中国联通对于大模型的未来,拥有足够的信心。

以上就是关于【中国联通为何进军大模型?】的相关消息了,希望对大家有所帮助!